Backpropagation

Gradient Descent MLP를 위한 특별한 케이스

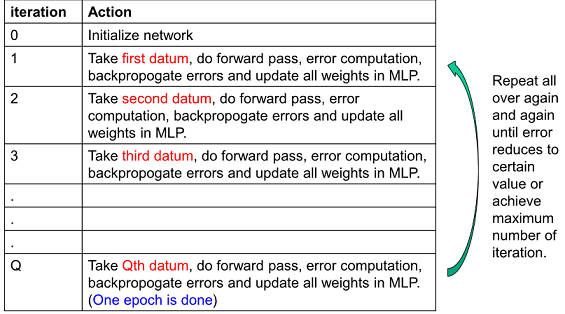

- Q 개의 학습데이터가 있음

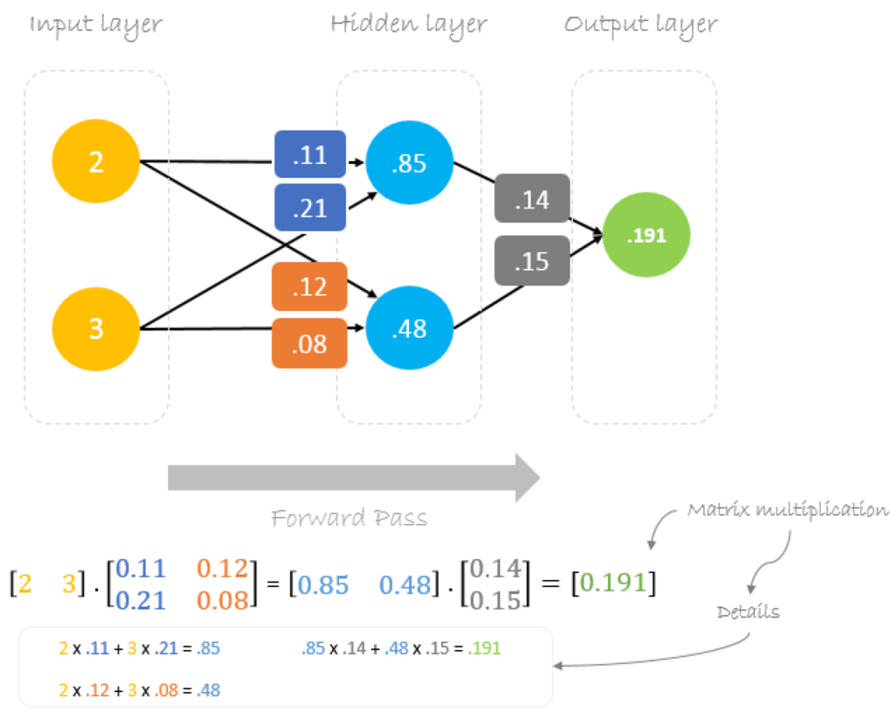

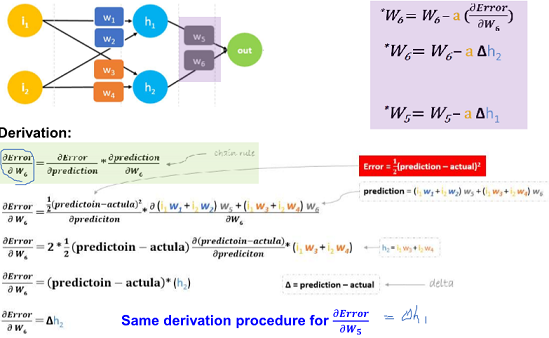

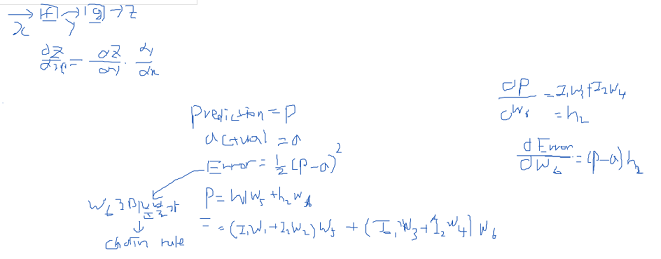

- Forward Pass

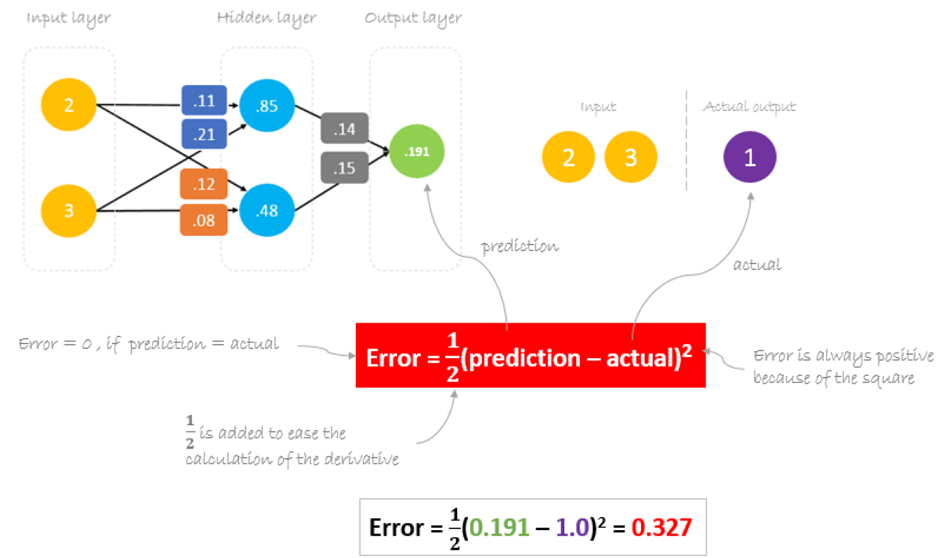

- Error Computation

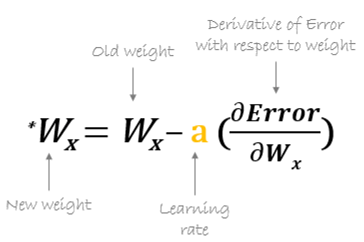

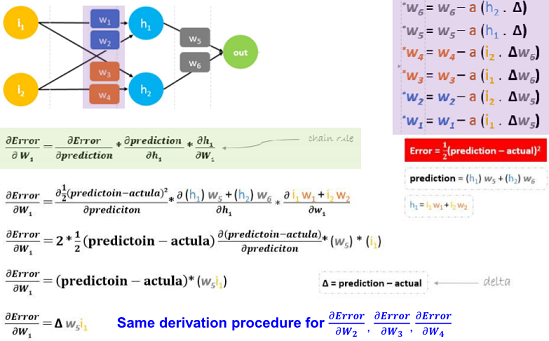

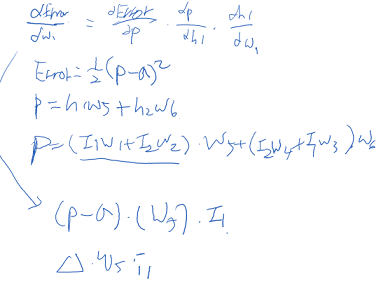

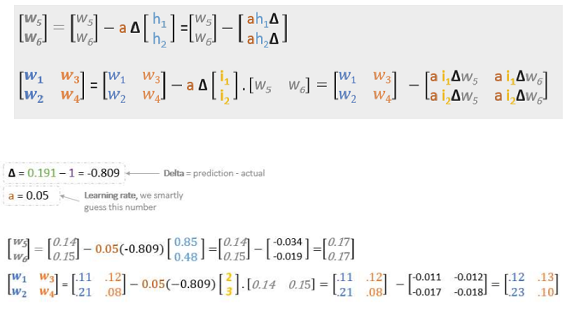

- Compute Weight Changes

- Update all weights of the network

1~5를 global error minimize를 찾기 위해 반복함

SGD로 설정되어 있으며 Q 학습데이터가 있을 때 Q번 모두 iteration 돌고나면 1 epoch를 다한 것임

Numerical Example

cf) https://hmkcode.github.io/ai/backpropagation-step-by-step/